19 de dez. de 2025

Privacidade de Dados em Atendimento com IA

Privacidade de dados em IA é uma preocupação crescente. Empresas que utilizam inteligência artificial no atendimento ao cliente enfrentam desafios para proteger informações pessoais, como CPF, endereços e históricos de compra. Apesar da LGPD, muitas plataformas populares no Brasil, como ChatGPT e Meta AI, ainda não cumprem integralmente os requisitos da lei.

Principais pontos:

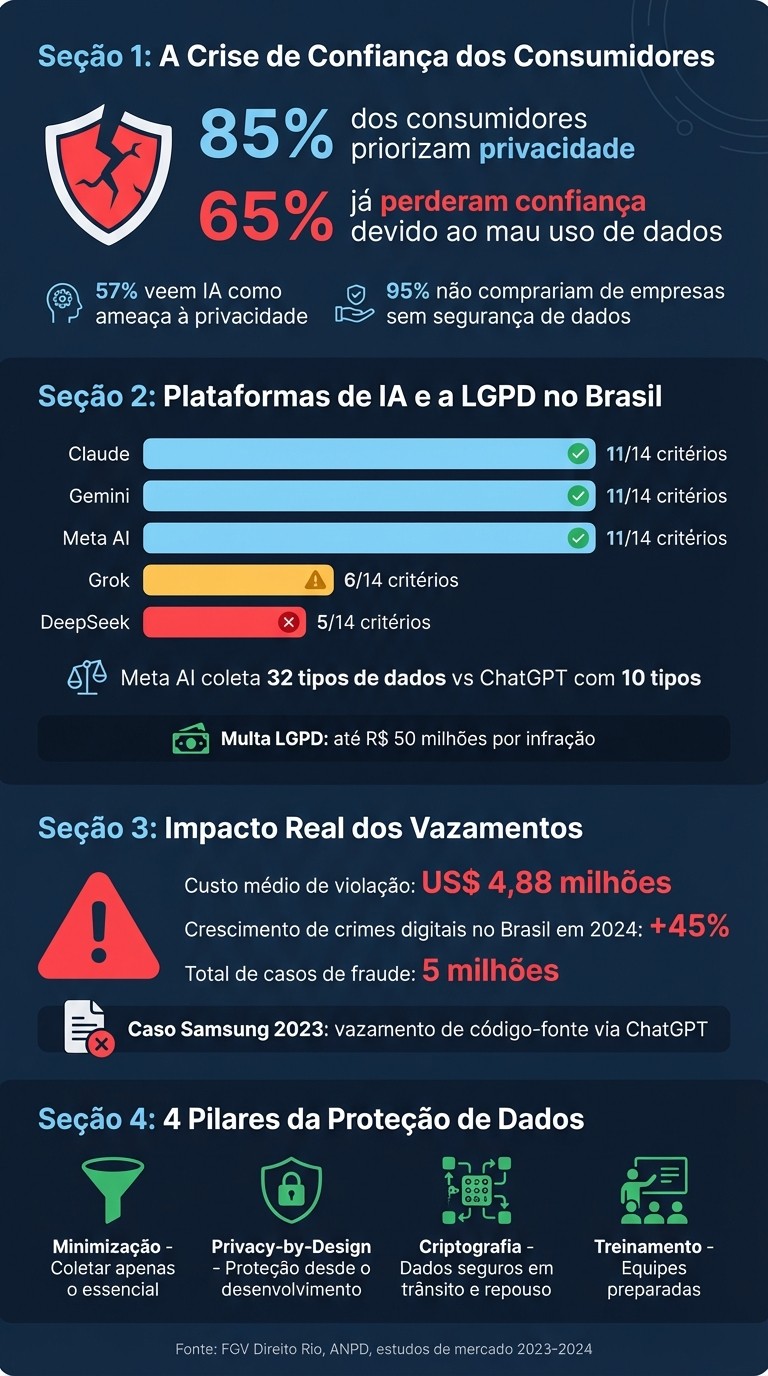

85% dos consumidores priorizam a privacidade ao lidar com marcas digitais, mas 65% já perderam a confiança devido ao mau uso de dados.

Sistemas de IA coletam e processam mais dados do que o necessário, muitas vezes sem consentimento explícito.

A LGPD exige transparência, direito de revisão humana e proteção rigorosa de informações sensíveis.

Casos como o vazamento de dados da Samsung e da Cerebral mostram os riscos de usar IA sem controles adequados.

A centralização de dados de múltiplos canais (WhatsApp, Instagram, etc.) aumenta a exposição a ciberataques.

Soluções:

Minimização de dados: Coletar apenas informações essenciais.

Privacy-by-Design: Incorporar proteção desde o desenvolvimento do sistema.

Controles de segurança: Criptografia, autenticação multifator e isolamento de dados.

Treinamento de equipes: Garantir que colaboradores saibam proteger informações.

Plataformas como SacGPT se destacam por integrar medidas de segurança, como isolamento de dados e escalonamento de interações sensíveis para humanos. Investir em proteção de dados não é apenas cumprir a lei, mas também conquistar a confiança dos clientes.

Estatísticas de Privacidade de Dados e IA no Brasil

Principais Desafios de Privacidade e Conformidade no Atendimento com IA

Cenários Comuns de Risco de Privacidade

Os problemas de privacidade envolvendo inteligência artificial vão muito além de simples vazamentos acidentais. Um dos maiores desafios é o armazenamento de dados sem clareza ou consentimento. Muitas plataformas utilizam conversas de clientes para treinar modelos futuros, mas sem informar de maneira transparente onde esses dados são armazenados, por quanto tempo e como serão descartados. Um exemplo disso é a OpenAI, que treinou seus modelos com uma base de 300 bilhões de palavras retiradas da internet, muitas vezes sem a autorização explícita dos autores originais.

Outro cenário preocupante é a exposição acidental de informações corporativas. Em 2023, a Samsung interrompeu o uso interno do ChatGPT após o vazamento de dados sensíveis do setor de semicondutores e trechos de código-fonte técnico. Isso aconteceu porque colaboradores usaram a ferramenta para obter assistência em tarefas técnicas, sem perceber que estavam compartilhando informações confidenciais. Casos como esse não são isolados: contratos, listas de clientes, CPFs e CNPJs são frequentemente copiados e colados em chats de IA para tarefas como resumir ou reformatar documentos, contribuindo inadvertidamente para alimentar bancos de dados com informações sigilosas.

Além disso, o problema do viés algorítmico merece atenção. Em 2018, a Amazon teve que abandonar um algoritmo de recrutamento que discriminava currículos com referências a "mulher". Isso aconteceu porque o sistema foi treinado com dados históricos que refletiam anos de padrões de contratação predominantemente masculinos. Mesmo dados que aparentemente foram "anonimizados" podem representar riscos. Modelos de IA conseguem captar lógicas de negócios ou padrões específicos que podem acabar sendo replicados em respostas fornecidas a terceiros ou até concorrentes. Esses exemplos mostram como as falhas de conformidade podem ter desdobramentos preocupantes, como será discutido na próxima seção.

Lacunas de Conformidade com a LGPD em Sistemas de IA

Muitas plataformas de IA enfrentam dificuldades em atender aos requisitos da Lei Geral de Proteção de Dados (LGPD). Problemas como consentimento inadequado, dificuldade em implementar o "direito ao esquecimento" e transferências internacionais de dados sem autorização são comuns. Uma pesquisa realizada pela FGV Direito Rio revelou que nenhuma das plataformas de IA generativa mais usadas no Brasil cumpre integralmente os requisitos mínimos da LGPD. Por exemplo, o DeepSeek, desenvolvido na China, atende apenas 5 de 14 critérios de segurança, enquanto o Grok, de Elon Musk, cumpre 6 de 14.

Em julho de 2024, a Autoridade Nacional de Proteção de Dados (ANPD) tomou uma medida preventiva contra a Meta, obrigando a empresa a suspender o uso de dados pessoais para treinar seus modelos de IA generativa no Brasil. A ANPD identificou um "risco grave" à privacidade, já que a Meta coletava dados de usuários do Facebook e Instagram sem oferecer uma forma clara de recusa ou consentimento informado. Vale lembrar que, sob a LGPD, empresas podem ser multadas em até R$ 50 milhões por infração.

"Treinar sistemas de IA com dados pessoais e sensíveis é uma faca de dois gumes: pode trazer avanços incríveis, mas também abrir portas para abusos se não houver uma governança adequada." - Caroline Muniz, Advogada especialista em Direito Digital, Machado Nunes Advogados Associados

Riscos de Privacidade em Múltiplos Canais de Comunicação

Outro fator que agrava os riscos de privacidade é a centralização de dados provenientes de diferentes canais de comunicação. Consolidar informações de WhatsApp, Instagram, Facebook, Telegram e sites em uma única plataforma de IA cria perfis de usuários extremamente detalhados. Caso esses dados sejam violados, o impacto é muito maior do que o de um vazamento isolado de um único canal. Por exemplo, a plataforma Meta AI coleta até 32 tipos diferentes de informações, que incluem biometria, orientação sexual e crenças religiosas, enquanto o ChatGPT coleta cerca de 10 tipos. Essa centralização torna essas plataformas alvos ainda mais atrativos para ciberataques, especialmente em um cenário onde crimes digitais no Brasil cresceram 45% em 2024, com cerca de 5 milhões de casos de fraude registrados.

Como Fortalecer a Privacidade de Dados no Atendimento com IA

Minimização e Classificação de Dados

O primeiro passo para proteger as informações dos clientes é coletar somente o essencial. Por exemplo, se você precisa do nome e endereço para realizar uma entrega, não há justificativa para pedir CPF, data de nascimento ou telefone secundário. Esse cuidado, conhecido como princípio da necessidade, ajuda a reduzir a exposição a riscos e facilita a gestão de dados.

Depois de coletados, os dados devem ser classificados de acordo com seu nível de sensibilidade. Uma boa prática é organizá-los em categorias como "Dados Diretos" (ex.: CPF, RG), "Dados Sensíveis" (ex.: saúde, religião, orientação sexual) e "Dados Digitais" (ex.: endereço IP, geolocalização). Essa organização permite aplicar medidas de segurança proporcionais ao risco envolvido. Por exemplo, informações relacionadas à saúde, finanças, justiça criminal ou dados de crianças exigem proteção mais rigorosa. Além disso, empresas que operam em vários canais de comunicação precisam garantir que os dados de cada cliente sejam usados exclusivamente para os agentes de IA daquela empresa, sem compartilhamento em modelos gerais. Com os dados minimizados e organizados, o próximo passo é integrar a privacidade diretamente no design do sistema.

Privacy-by-Design em Sistemas de IA

Incorporar privacidade desde o início do desenvolvimento é muito mais eficiente do que corrigir falhas mais tarde. Isso significa implementar anonimização ou pseudonimização logo na coleta de dados, garantindo que apenas informações estritamente necessárias sejam usadas para treinar os modelos de IA. A Autoridade Nacional de Proteção de Dados (ANPD) reforça que "o princípio da transparência é especialmente relevante no contexto do uso e desenvolvimento responsável de sistemas de IA". Na prática, isso inclui oferecer aos usuários explicações claras sobre como suas mensagens são processadas e se os dados serão utilizados para aprimorar futuros modelos.

Outra medida essencial é testar o desempenho da IA em ambientes de simulação ou sandbox, utilizando dados históricos antes de aplicá-la a interações reais. Além disso, configure automação seletiva: deixe que motores de workflow decidam quais atendimentos a IA deve gerenciar e escale automaticamente para agentes humanos conversas que envolvam dados sensíveis, como informações de saúde ou números de cartão de crédito. É importante lembrar que 61% das pessoas ainda têm receio de confiar inteiramente em sistemas de IA. Por isso, oferecer uma opção de "opt-out" para decisões automatizadas e garantir o suporte de atendentes humanos é indispensável.

Implementação de Controles de Segurança

Proteger os dados dos clientes exige uma combinação de tecnologia e processos bem definidos. Criptografia avançada para dados em repouso e em trânsito, autenticação multifator (MFA) e permissões baseadas em função são medidas que ajudam a limitar o acesso às informações sensíveis. O custo médio de uma violação de dados chegou a US$ 4,88 milhões, e 95% dos consumidores afirmam que não comprariam de uma empresa se não confiassem na segurança de seus dados.

Outra prática importante é o uso de mascaramento de dados em ambientes de desenvolvimento e teste, permitindo que os desenvolvedores trabalhem sem expor informações reais dos usuários. Sistemas de monitoramento com IA também são úteis para identificar anomalias em tempo real, como tentativas de login em horários ou locais incomuns. Ao contratar fornecedores de plataformas de IA, garanta que os contratos incluam cláusulas de isolamento de dados, impedindo que informações de seus clientes sejam utilizadas para melhorar modelos gerais do fornecedor. Verifique ainda se o provedor possui certificação SOC 2 Type II, que assegura padrões rigorosos de segurança. Por fim, realize auditorias regulares com ferramentas automatizadas para identificar vulnerabilidades e garantir que apenas pessoas autorizadas tenham acesso a dados sensíveis.

Escolhendo uma Plataforma de Atendimento com IA com Recursos Robustos de Privacidade

Checklist de Conformidade de Privacidade e Segurança

Antes de optar por uma plataforma, é essencial verificar se a política de privacidade e os termos de uso estão disponíveis em português, garantindo transparência para os usuários no Brasil. Se a documentação não estiver localizada, isso já pode indicar um descaso com a conformidade à LGPD. Além disso, certifique-se de que o sistema utiliza criptografia de ponta a ponta, possui certificado SSL válido e oferece controles de acesso seguros, como autenticação multifator (MFA), conforme exigido pela LGPD.

Outro ponto importante é a presença de um Encarregado de Dados (DPO) claramente identificado, com informações de contato acessíveis. Um levantamento da FGV mostrou que plataformas como Claude, Gemini e Meta AI atendem a 11 dos 14 critérios mínimos de conformidade com a LGPD, enquanto a DeepSeek cumpre apenas 5. Também é essencial que a plataforma ofereça capacidade de auditoria, permitindo que os processos de dados sejam transparentes e verificáveis. Como destaca Waldemar Gonçalves, Diretor-Presidente da ANPD:

"Dados pessoais usados em processos automatizados devem ser transparentes, verificáveis e auditáveis".

Seguindo esses critérios, você terá uma base sólida para escolher uma plataforma que priorize a privacidade. Depois de verificar esses requisitos, avalie como essas medidas são implementadas na prática.

Como o SacGPT Atende aos Requisitos de Privacidade e Segurança

O SacGPT se destaca por integrar a comunicação de diversos canais (WhatsApp, Instagram, Facebook, Telegram e site) em uma única interface. Isso facilita o controle centralizado dos fluxos de dados, reduzindo os riscos associados à dispersão de informações. A plataforma também conta com uma transferência inteligente para atendentes humanos, garantindo que interações envolvendo dados sensíveis sejam escaladas automaticamente.

Outro diferencial é a possibilidade de integrar uma base de conhecimento e utilizar reconhecimento de multimídia, permitindo fluxos de mensagens automatizados sem comprometer a segurança. Ferramentas de organização de equipe e rastreamento ajudam a implementar permissões baseadas em função, limitando o acesso a dados apenas a colaboradores autorizados. Com planos a partir de R$ 120/mês, o SacGPT oferece recursos como busca em tempo real na web, acompanhamento ativo e transferência para humanos, atendendo desde pequenas empresas até grandes operações.

Mesmo com essas funcionalidades, é fundamental questionar diretamente os fornecedores para confirmar o cumprimento dessas práticas.

Perguntas para Fazer aos Fornecedores de Plataformas

Algumas perguntas podem ajudar a garantir que a plataforma escolhida atende aos padrões de privacidade e segurança:

"Os dados dos meus clientes são utilizados para treinar modelos gerais da plataforma ou ficam isolados?" Certifique-se de que o fornecedor oferece cláusulas que garantam o isolamento de dados.

"Vocês possuem certificação SOC 2 Type II?" Essa certificação é um forte indicador de que a plataforma segue normas rigorosas de segurança.

"Se os dados forem transferidos para fora do Brasil, quais mecanismos legais vocês utilizam?" A ANPD exige que as plataformas detalhem se há transferência internacional e utilizem cláusulas contratuais apropriadas.

"A plataforma permite realizar Avaliação de Impacto à Proteção de Dados (AIPD) para aplicações de alto risco?" Isso é essencial para sistemas que processam dados sensíveis ou realizam decisões automatizadas, como em processos de recrutamento.

"Vocês oferecem um período de teste gratuito?" Algumas plataformas disponibilizam até 10 dias para que você avalie os controles de privacidade antes de fechar contrato.

Essas perguntas ajudam a garantir que a plataforma escolhida está alinhada com as melhores práticas de proteção de dados e privacidade.

LGPD e Inteligência Artificial: exposição ou proteção de dados?

Mantendo os Padrões de Privacidade à Medida que os Sistemas de IA Evoluem

Depois de implementar controles rigorosos e escolher a plataforma certa, é essencial revisar e adaptar constantemente essas práticas à medida que a IA avança.

Auditorias de Privacidade e Atualizações Regulares

Privacidade não é algo que se faz uma vez e pronto; é um processo contínuo. Monitorar ativamente ajuda a identificar rapidamente anomalias e atividades suspeitas, permitindo respostas rápidas a possíveis ameaças à segurança. Para isso, é importante:

Realizar avaliações regulares de vulnerabilidade.

Aplicar atualizações imediatas para corrigir falhas.

Testar os controles de segurança após mudanças no sistema ou em regulamentações.

Manter registros detalhados de todas as interações para garantir transparência e facilitar auditorias externas.

Outra prática essencial é revisar frequentemente as políticas de retenção de dados, garantindo que as informações sejam armazenadas apenas pelo tempo estritamente necessário. Como bem coloca a Jenni AI:

"Garantir a santidade dos dados do usuário não é apenas um requisito técnico, mas uma obrigação moral que sustenta a implementação ética das tecnologias de IA."

Treinamento de Equipes sobre Privacidade de Dados

Além das medidas técnicas, preparar a equipe é indispensável para proteger os dados. Funcionários treinados são a primeira barreira de defesa. Promova treinamentos regulares sobre temas como ética digital, uso responsável da IA e os riscos da 'Shadow AI' - o uso não supervisionado de ferramentas públicas que pode expor dados sensíveis.

Estabeleça também comitês internos de ética para avaliar o impacto de sistemas de IA antes do lançamento e revisar decisões automatizadas que possam gerar consequências negativas.

Tenha um plano de resposta a incidentes bem estruturado, com passos claros para lidar com possíveis vazamentos de dados. Esse plano deve incluir protocolos para notificar imediatamente autoridades e usuários. Como destaca Maurício Santos Manzueto, Diretor de TI do BTG Pactual:

"O debate sobre privacidade e ética no uso de agentes de IA não é apenas técnico, é essencialmente social."

Como o SacGPT Apoia a Gestão de Privacidade

O SacGPT oferece ferramentas específicas para ajudar empresas a manter altos padrões de privacidade enquanto lidam com tecnologias em evolução. Com o modo de simulação, é possível testar as respostas da IA usando milhares de tickets históricos, identificando falhas de privacidade sem expor dados reais de clientes.

Além disso, as ferramentas de análise integradas permitem monitorar, em tempo real, o desempenho da IA e sua conformidade com práticas de privacidade, facilitando ajustes rápidos em resposta a mudanças tecnológicas ou regulatórias.

Outro recurso importante é o motor de fluxos de trabalho automatizados, que garante supervisão adequada ao escalar automaticamente interações sensíveis para atendentes humanos. O SacGPT também implementa isolamento de dados, assegurando que as informações de uma empresa sejam usadas apenas por seus próprios agentes de IA, sem serem compartilhadas para treinar modelos de outros clientes.

Com suporte para conformidade SOC 2, criptografia avançada e opções de residência de dados específicas, o SacGPT ajuda empresas a atenderem padrões globais de proteção de dados, como o GDPR e a LGPD.

Conclusão

Hoje, a privacidade de dados deixou de ser apenas uma obrigação legal e se tornou um dos pilares da experiência do cliente. Como a eesel.ai destaca:

"A privacidade não é mais apenas uma caixa de seleção legal; é uma parte fundamental da experiência do cliente."

Os números não mentem: 95% dos consumidores afirmam que evitariam comprar de uma empresa caso não sentissem seus dados protegidos. Além disso, 57% enxergam a inteligência artificial como uma ameaça à privacidade. Nesse contexto, alinhar os fluxos de trabalho de IA com a LGPD não é apenas uma exigência legal, mas uma estratégia para conquistar e manter a confiança do cliente.

Práticas como Privacy-by-Design, minimização de dados e isolamento de informações são ferramentas poderosas para reduzir vulnerabilidades. Afinal, o custo de um vazamento de dados pode ultrapassar milhões, enquanto investir em prevenção é muito mais viável e eficiente.

O SacGPT surge como um aliado nesse cenário, oferecendo soluções que simplificam a proteção de dados. Com recursos como modo de simulação, isolamento de dados e fluxos automatizados que direcionam interações sensíveis para atendentes humanos, a ferramenta ajuda empresas a cumprir a LGPD e padrões globais, como o GDPR. Além disso, sua conformidade com SOC 2, criptografia avançada e armazenamento local de dados reforçam a segurança.

Diante de um cenário onde 65% dos consumidores já perderam a confiança em marcas devido ao uso inadequado de informações, investir em segurança e conformidade não é apenas uma precaução, mas uma forma de fortalecer relações e se manter competitivo no mercado.

FAQs

Como a LGPD impacta o uso de inteligência artificial no atendimento ao cliente?

A Lei Geral de Proteção de Dados (LGPD) estabelece que o uso de inteligência artificial no atendimento ao cliente deve seguir princípios como transparência, necessidade, segurança e o consentimento explícito dos usuários. Na prática, isso exige que as empresas tratem os dados com responsabilidade, evitando a coleta de informações desnecessárias e garantindo proteção contra acessos indevidos.

Outro ponto crucial é respeitar os direitos dos titulares, permitindo que eles acessem, corrijam ou solicitem a exclusão de seus dados pessoais. Adotar essas medidas não apenas evita problemas legais, mas também reforça a confiança dos clientes na marca e nos serviços oferecidos.

Como proteger os dados pessoais em sistemas de IA no atendimento ao cliente?

Para proteger dados pessoais em sistemas de IA no atendimento, algumas práticas são indispensáveis:

Confidencialidade: Use criptografia e controle de acesso para proteger as informações.

Consentimento informado: Sempre obtenha a permissão dos clientes antes de coletar ou usar dados pessoais.

Transparência: Deixe claro como os dados estão sendo armazenados e utilizados.

Auditorias frequentes: Revise regularmente o sistema para identificar e corrigir possíveis falhas.

Conformidade com a LGPD: Siga as diretrizes da Lei Geral de Proteção de Dados e outras normas aplicáveis.

Também é crucial incluir supervisão humana no processo. Isso ajuda a evitar decisões automáticas enviesadas e garante que a tecnologia seja usada de forma ética e responsável.

Quais são os principais riscos ao consolidar dados de diferentes canais em uma única plataforma de IA?

Consolidar informações de diferentes canais em uma única plataforma de IA pode trazer riscos consideráveis. Entre eles estão a exposição a vazamentos de dados, possíveis ataques cibernéticos e o uso indevido de informações sensíveis. Além disso, há o desafio de atender às exigências de legislações como a LGPD (Lei Geral de Proteção de Dados), o que demanda uma gestão cuidadosa e rigorosa para garantir a segurança das informações.

Para reduzir esses riscos, é essencial implementar medidas de segurança eficazes, como o uso de criptografia, controles rigorosos de acesso e monitoramento constante. Essas práticas ajudam a proteger os dados contra ameaças e a manter a conformidade com as regulamentações aplicáveis.